Von POC zu produktivem Einsatz: Warum eine skalierbare Plattform unerlässlich ist

Zwar setzen sich viele Unternehmen mit dem Thema Künstliche Intelligenz (KI) auseinander, doch oft bleibt es bei Pilotprojekten (POCs), die nie in den produktiven Betrieb überführt werden. Der Grund dafür liegt selten in der Technologie selbst, sondern vielmehr in der fehlenden Reife der Architektur, der mangelnden Integration in bestehende Prozesse und dem Fehlen eines soliden Betriebsmodells.

Für den produktiven Einsatz von KI ist mehr erforderlich als ein Modell mit guten Metriken. Benötigt wird eine Architektur, die Sicherheit, Skalierbarkeit, Monitoring, Datenmanagement, Kontextverständnis und Governance zusammenführt und dabei auf regulatorische Anforderungen, Nutzergruppen und IT-Umgebungen abgestimmt ist. Nur so lassen sich Geschäftswert, Effizienz und Compliance gleichermaßen sicherstellen.

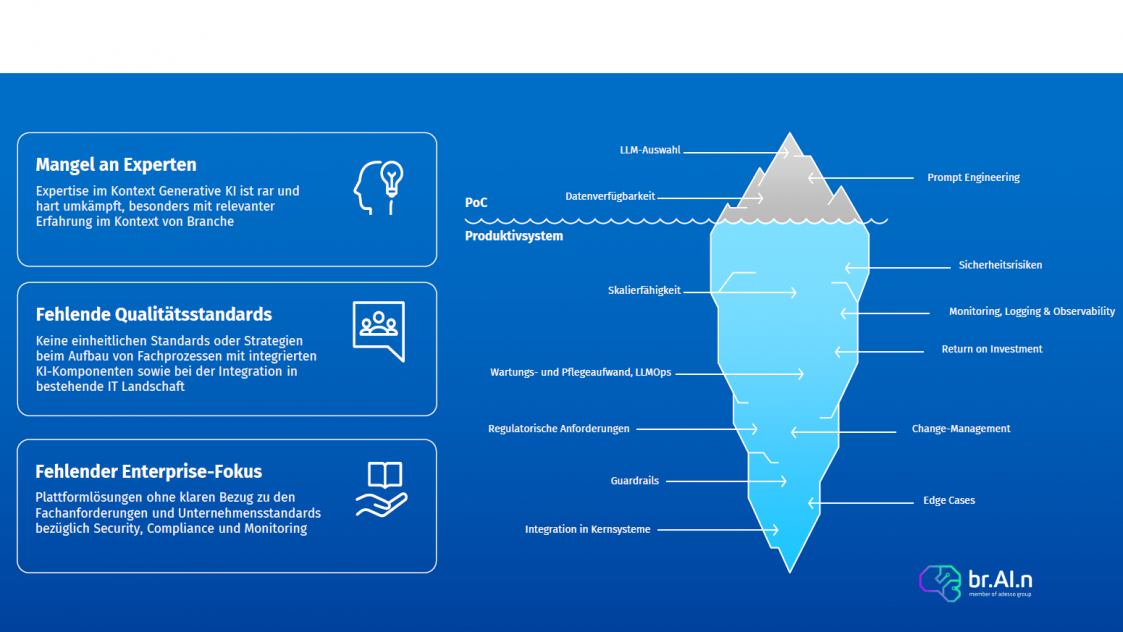

Wie in der obigen Abbildung dargestellt, sind für einen Proof of Concept (PoC) meist nur Datenverfügbarkeit, Prompt Engineering und die Auswahl des passenden LLMs entscheidend. In einem produktiven Einsatz reicht das jedoch bei weitem nicht aus. Diese Aspekte bilden lediglich die Spitze des Eisbergs.

Eine belastbare und produktionsreife Lösung muss deutlich mehr abdecken, insbesondere:

Nur wenn all diese Dimensionen berücksichtigt werden, kann Generative AI verlässlich, sicher und wirtschaftlich im Unternehmen betrieben werden.

Diese Architektur lässt sich auf verschiedene Arten realisieren. Um jedoch sicherzustellen, dass die oben genannten Aspekte abgedeckt sind und gleichzeitig die Time-to-Production für Standard-Use-Cases im Rahmen von wenigen Wochen statt Monaten bleibt – ist eine robuste Plattform unverzichtbar.

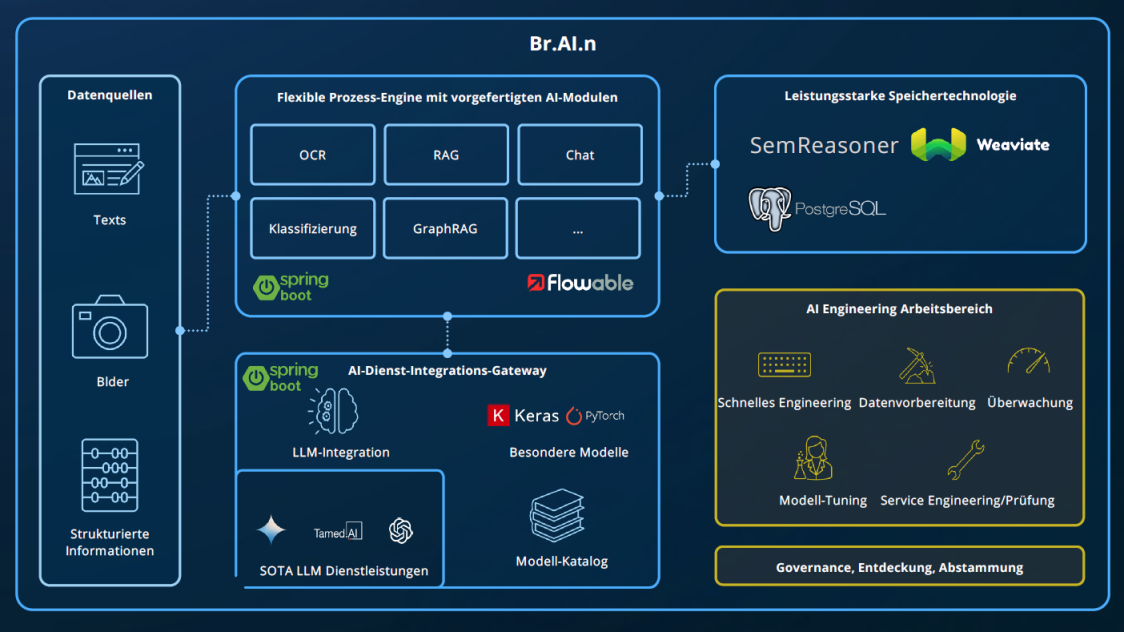

Die im Folgenden beschriebenen Use Cases wurden mit der Plattform br.AI.n von adesso realisiert – einer Java-basierten Enterprise-Low-Code-Plattform, die den Aufbau generativer KI-Workflows mit konfigurierbaren Standardbausteinen in BPMN 2.0-Notation ermöglicht.

Die br.AI.n Plattform verbindet alle Komponenten, die für eine skalierbare, sichere und produktionsreife Generative-AI-Umsetzung notwendig sind: Von der Datenaufnahme über modulare KI-Dienste, leistungsstarke Speicher- und Retrieval-Technologien bis hin zu einem Engineering-Arbeitsbereich für Datenvorbereitung, Tuning und Governance – alles orchestriert über standardisierte Prozessmodelle und integrativ erweiterbar.

evia ist Integrations- und Vertriebspartner von br.AI.n, denn: Auch mit der besten Plattform braucht es das passende Know-how und erfahrene Ressourcen, um das volle Potenzial auszuschöpfen.

Im vorherigen Blogbeitrag haben wir bereits einen Use Case zur automatisierten Antragsdatenerfassung vorgestellt, der gemeinsam mit der Investitionsbank Schleswig-Holstein (IB.SH) auf Basis der br.AI.n-Plattform realisiert wurde. Dieses Mal werfen wir einen Blick auf zwei weitere Anwendungsszenarien: Zum einen die Prüfung von Verträgen auf Konformität mit der DORA-Verordnung, zum anderen die Überprüfung von Lieferantendokumenten auf Übereinstimmung mit dem Code of Conduct eines Großabnehmers.

Automatisierte Vertragsprüfung nach DORA: Digitale Operational Resilience in der Praxis

Die DORA-Verordnung (Digital Operational Resilience Act) der EU verpflichtet seit 2025 alle Finanzunternehmen – darunter Banken, Versicherungen und Kapitalverwaltungsgesellschaften – zu einem umfassenden Rahmenwerk für digitale Resilienz. Ziel ist es, sicherzustellen, dass kritische Geschäftsprozesse auch im Falle von Cyberangriffen, Systemausfällen oder Störungen bei Drittanbietern stabil bleiben.

Ein zentraler Bestandteil von DORA ist das Vertrags- und Lieferantenmanagement. Und z.B. Verträge mit IT- und Cloud-Dienstleistern müssen klare Anforderungen erfüllen, etwa in Bezug auf:

Da Verträge oft sehr umfangreich und unterschiedlich strukturiert sind, ist die manuelle Prüfung extrem aufwendig und fehleranfällig. Hier setzt die br.AI.n-Plattform an, indem sie Verträge automatisiert analysiert, relevante Klauseln identifiziert und deren Konformität mit den regulatorischen Anforderungen von DORA überprüft.

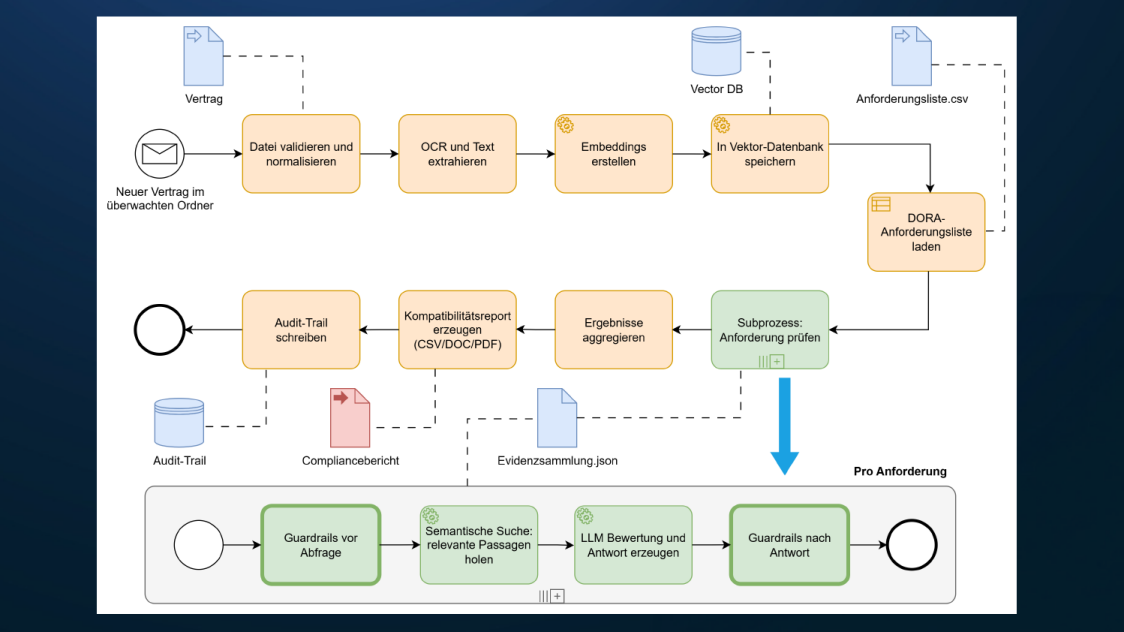

Die Abbildung zeigt ein grobes High-Level-Diagramm des in BPMN modellierten Prozesses zur Prüfung der DORA-Konformität. Der produktive Workflow enthält zusätzliche Prüfungen, Gateways, Fehlerbehandlung und Eskalationen. Das vereinfachte Beispiel vermittelt jedoch gut, wie die Lösung arbeitet. Der modellierte Workflow übersetzt sich direkt in ein lauffähiges Backend mit REST APIs. Dieses Backend wird deployt und mit einer individuell entwickelten oder bereits vorhandenen UI verbunden.

Kernlogik in Stichpunkten

Was die Implementierung so direkt macht

Die BPMN-Definition läuft auf der br.AI.n Plattform mit einer BPMN-Engine. Jede Task ist als Service Task oder Call Activity hinterlegt und ruft die entsprechenden Backend-Services auf, zum Beispiel OCR, Embedding Service, Retrieval, LLM Scoring, Reporting. Die Engine übernimmt Orchestrierung, Fehler- und Wiederhollogik, Korrelation der Instanzen sowie das Persistieren von Zuständen und Audit-Logs. Über REST APIs lässt sich der Workflow aus einer UI starten, überwachen und auswerten.

Das Diagramm ist nicht nur Dokumentation. Es ist die Spezifikation des produktiven Ablaufs und damit die Grundlage für ein nachvollziehbares, skalierbares und auditierbares System. Durch die Kombination aus BPMN Orchestrierung, Vector DB Retrieval, LLM-Bewertung und Guardrails entstehen reproduzierbare Ergebnisse mit klarer Evidenz. Genau das ist für DORA essenziell und erlaubt den Übergang von einem POC zu einer robusten Lösung auf Enterprise-Niveau.

Betrieb und Deployment

Die Lösung kann flexibel bereitgestellt werden: in der Public Cloud, in deutschen Sovereign-Cloud-Umgebungen sowie vollständig on premises im Rechenzentrum. Gerade im DORA-relevanten Finanzsektor sind Datenresidenz, Kontrollhoheit und Auditfähigkeit zentral. Unabhängig vom Betriebsmodell bleiben APIs und Funktionsumfang identisch, Infrastruktur as Code erleichtert Rollout und Wartung. Netzisolierung, Schlüsselmanagement und Anbindung an bestehende Security- und GRC-Prozesse sind integriert.

Automatisierte CoC-Prüfung bei Lieferanten

Ein sehr ähnlicher Praxis-Use Case: die Sicherstellung, dass die Codes of Conduct der Lieferanten eines großen Industrieunternehmens inhaltlich mit dem CoC des Käufers übereinstimmen. Das ist wichtig für rechtliche Anforderungen, Reputationsschutz, ESG-Vorgaben und Beschaffungsrichtlinien. Abweichungen können zu Audit-Findings, Vertragsrisiken und Lieferanten-Sperren führen.

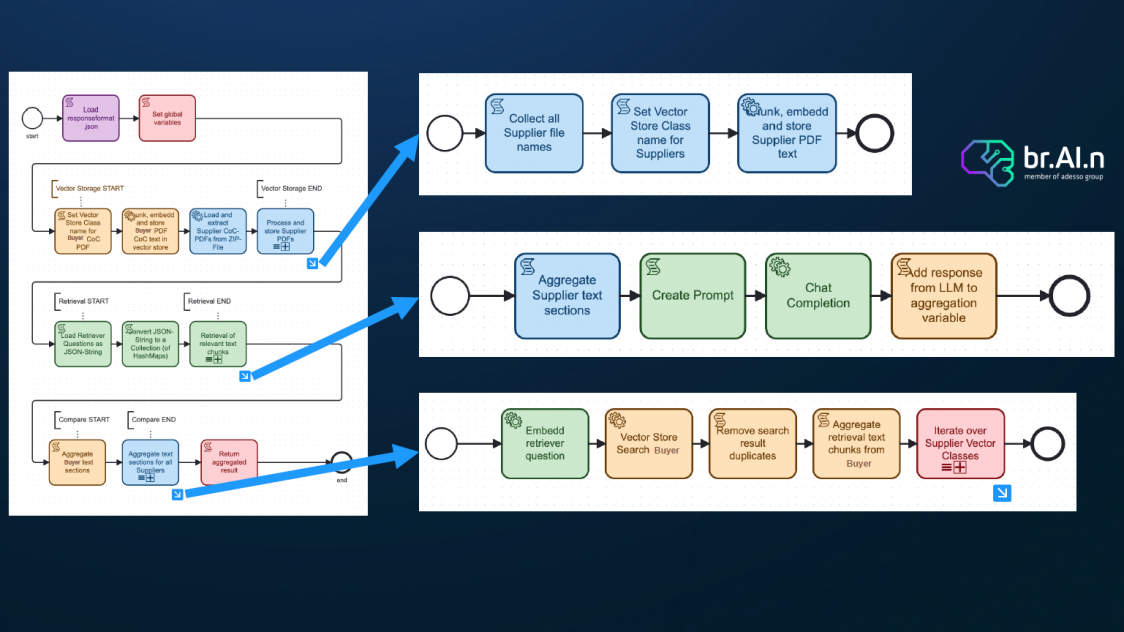

Der wesentliche Unterschied zu DORA: es gibt hier keinen formalisierten Paragraphen-Katalog. Stattdessen extrahiert die AI die relevanten Leitprinzipien und Kontrollpunkte aus dem CoC des Käufers und vergleicht sie semantisch mit den CoCs der Lieferanten, erkennt also auch sinngleiche, anders formulierte Aussagen oder Lücken.

Robustes Vorgehen auf Basis von Embeddings

High-level BPMN-Diagramm

Warum nicht beide CoCs einfach in ein starkes LLM mit großem Context Window geben?

Weil ein LLM-only Ansatz bei Länge und Anzahl der Dokumente schnell unskalierbar und teuer wird, die Ergebnisse schwer reproduzierbar sind und die Nachweisführung leidet. Mit Embeddings und Vector Store holen wir für jede Frage nur die wirklich relevanten Passagen, reduzieren Tokens und Kosten, senken Halluzinationen, verankern jede Aussage an Evidenzstellen mit Zitaten, ermöglichen konsistentes Punkt-für-Punkt Matching auch bei anders formulierter Semantik, wiederverwenden Indizes für neue Lieferanten oder Updates und erfüllen Audit- und Compliance-Anforderungen durch stabile, nachvollziehbare Pipelines. Kurz gesagt, Retrieval plus LLM liefert präziser, günstiger, reproduzierbarer und auditierbar, gerade bei vielen CoCs.

Regulatorisch sicher und reproduzierbar: EU AI Act und ISO 42001 mit Validaitor

Gerade in regulierten Branchen wächst der Druck, KI nachvollziehbar, sicher und auditierbar zu betreiben. Damit unsere Lösung die Anforderungen des EU AI Act und der ISO 42001 erfüllt und zugleich konsistente, genaue Ergebnisse liefert, integrieren wir Validaitor. Das Tool vereint automatisierte Compliance, Governance und Testing der KI-Lösungen und Modelle. Ergebnis: revisionssichere Nachweise, reproduzierbare Qualität und stabile Resultate, unabhängig von LLM- oder Infrastrukturwechseln.